Dieser Beitrag stellt die wichtigsten Regelungen der KI-Verordnung für Arbeitgeber vor.

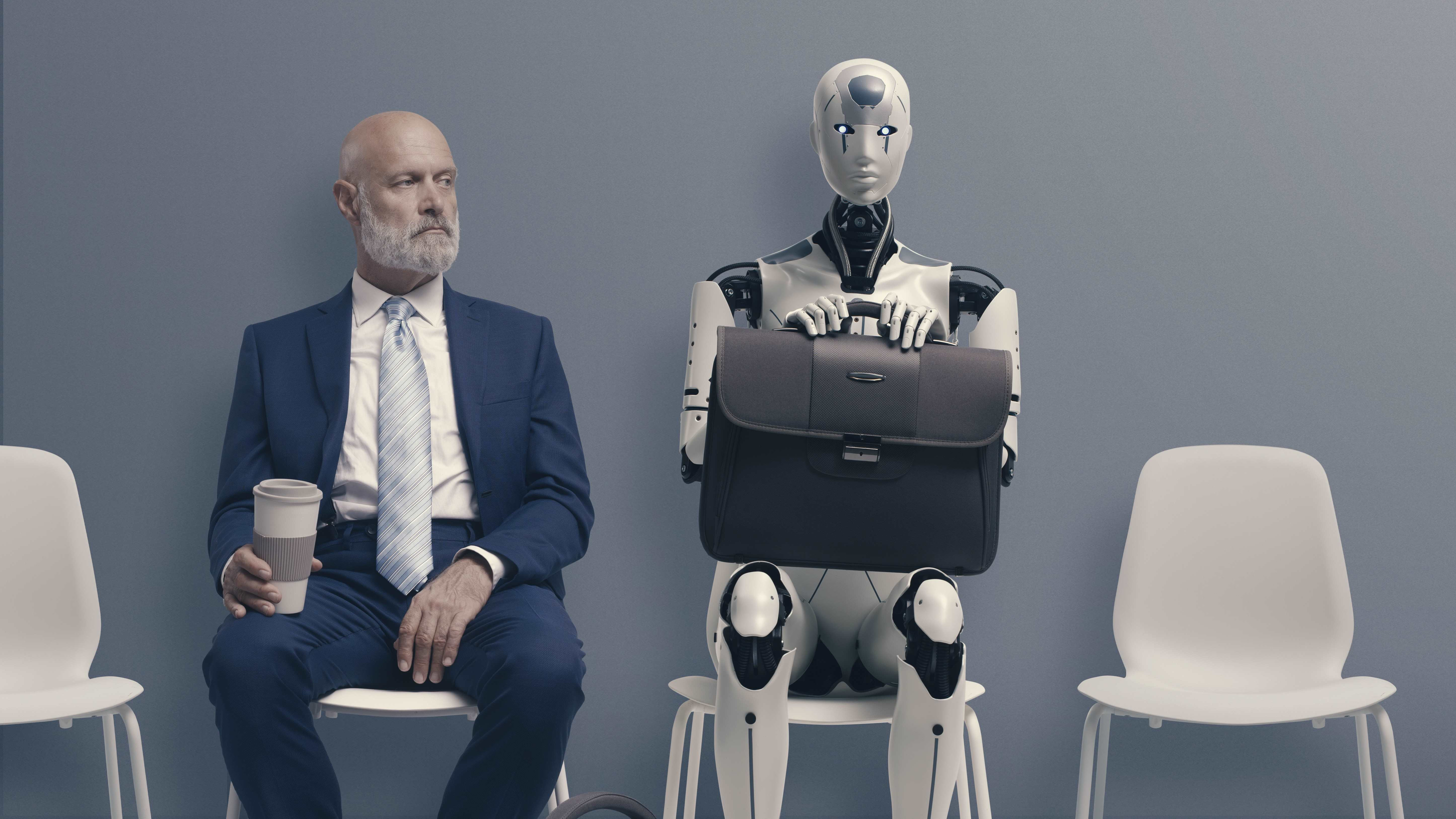

Die Europäische Union hat eine Vorreiterrolle bei der Regulierung von Künstlicher Intelligenz (KI) übernommen. Als Reaktion auf die rasche Verbreitung von KI-Systemen und deren potenzielle Auswirkungen auf Gesellschaft, Wirtschaft und Ethik arbeitet die EU derzeit an zwei wichtigen Instrumenten: KI-Verordnung und KI-Haftungsrichtlinie. Diese beiden Regelungen sollen das Vertrauen der Bürgerinnen und Bürger in KI stärken, die Verantwortlichkeit von KI-Systemen klären und eine ethisch vertretbare Nutzung sicherstellen. Die KI-Haftungsrichtlinie ist Gegenstand von Teil 2 des Blogbeitrags.

Ende 2023 soll eine Einigung über die Ausgestaltung der KI-Verordnung vorliegen

Im April 2021 hat die Europäische Kommission erstmals einen Entwurf für eine KI-Verordnung (KI-VO-E) vorgelegt. Dies ist der erste Versuch, eine robuste Regulierung für KI zu schaffen. Nachdem sich das EU-Parlament am 14. Juni 2023 über seinen finalen Kompromissvorschlag zur geplanten KI-Verordnung geeinigt hat, befindet sich der Entwurf derzeit in den Trilog-Verhandlungen zwischen der Europäischen Kommission, dem Rat der Europäischen Union und dem Europäischem Parlament. Ziel ist es, bis Ende 2023 eine Einigung über die Ausgestaltung der Verordnung zu erzielen.

Zielsetzung und sachlicher Geltungsbereich der KI-Verordnung

Die Verordnung bezweckt, dass KI sicher, transparent und nachhaltig gestaltet und eingesetzt wird. Zudem sollen mögliche Risiken von KI im Bereich der Grundrechtsgefährdung adressiert werden.

Die Verordnung soll im Wesentlichen sowohl für Anbieter als auch Nutzer/Betreiber von KI-Systemen gelten, sofern die KI-Systeme selbst oder deren Ergebnisse in der EU genutzt werden. Arbeitgeber werden in der Regel als Nutzer/Betreiber von KI-Systemen anzusehen sein.

KI-Systeme lassen sich – vorbehaltlich der Ergebnisse des Trilogs zu Art. 3 Nr. 1 – generell als autonom agierende Systeme beschreiben, die auf der Grundlage verschiedener Ansätze (wie maschinelles Lernen, Logik und Wissen oder Statistik) operieren und Outputs generieren, die ihre Umwelt beeinflussen.

Welchen Pflichten Arbeitgeber unterliegen werden, richtet sich nach dem Risiko des eingesetzten KI-Systems

Der Verordnungsgeber verfolgt einen risikobasierten Ansatz, indem er zwischen KI-Systemen mit unannehmbarem Risiko, KI-Systemen mit hohem Risiko und sonstigen KI-Systemen unterscheidet.

Ein unannehmbares Risiko liegt vor, wenn eine Gefahr für den Menschen besteht, insbesondere wenn das KI-System das Potenzial hat, Menschen durch den Einsatz unterschwelliger Beeinflussungstechniken zu manipulieren. Beispiele hierfür sind das Social-Scoring-System, biometrische Echtzeitüberwachung im öffentlichen Raum oder prädiktive Polizeisysteme. Diese sind nach Titel II der Verordnung grundsätzlich verboten.

Titel III befasst sich als Kernstück der Verordnung mit Hochrisiko-KI-Systemen, die erhebliche Risiken für die Gesundheit und Sicherheit oder die Grundrechte von Personen bergen. Dazu gehören auch KI-Systeme, die in Produkten eingesetzt werden, die unter die Produktsicherheitsvorschriften der EU fallen, wie medizinische Geräte, Aufzüge oder Spielzeug. Für Arbeitgeber wird sich besonders bemerkbar machen, dass im Personalbereich eingesetzte KI regelmäßig ein hohes Risiko aufweisen wird, da Art. 6 Abs. 2 i.V.m. Anhang III Nr. 4 solche Systeme umfasst, die bestimmungsgemäß insbesondere für Einstellungen, Beförderungen und Kündigungen verwendet werden sollen.

Hochrisiko-KI-Systeme unterliegen strengen Vorschriften, bevor sie auf den Markt gebracht werden dürfen. Außerdem müssen sie während des gesamten Lebenszyklus bewertet werden (Art. 29): So unterliegt der Nutzer/Betreiber der Pflicht, ein Hochrisiko-KI-System gemäß den Gebrauchsanweisungen zu verwenden und dessen Betrieb anhand dieser Gebrauchsanweisungen zu überwachen. Soweit er Kontrolle über die Daten hat, muss er außerdem dafür sorgen, dass die Eingabedaten der Zweckbestimmung des Systems entsprechen sowie die automatisch erzeugten Protokolle des Systems aufbewahren.

Nach dem Vorschlag des Europäischen Parlaments müssen die Nutzer/Betreiber vor der Inbetriebnahme von Hochrisiko-KI zunächst eine Grundrechtsprüfung nach Art. 29a durchzuführen. Unter anderem soll dabei berücksichtigt werden, welche Personengruppen von dem KI-Einsatz betroffen sein werden. Darüber hinaus sind nach Art. 29 Abs. 5a vor dem Einsatz von Hochrisiko-KI am Arbeitsplatz die Arbeitnehmervertreter zu konsultieren und darüber zu informieren, dass sie dem System unterliegen werden.

Darüber hinaus möchte das Europäische Parlament, dass die Nutzer/Betreiber aller KI-Systeme allgemeine Datenschutz-, der Transparenz- und Gleichbehandlungsgrundsätze nach Art. 4a und 4b befolgen. Für Arbeitgeber bedeutet dies, dass sie die Möglichkeit der menschlichen Aufsicht und ein ausreichendes Maß an KI-Kompetenz ihrer Arbeitnehmer sicherstellen müssen. Im Falle des Einsatzes eines KI-Systems mit hohem Risiko verlangt Art. 29 Abs. 1a die tatsächliche Einführung einer menschlichen Aufsicht.

Welche Maßnahmen Arbeitgeber jetzt schon ergreifen sollten

Um bei dem Einsatz von Zukunftstechnologien mithalten zu können, sollten Arbeitgeber sich frühzeitig mit der Einbindung von KI im Betrieb auseinandersetzen. Damit einher geht die Notwendigkeit, die legislative Entwicklung des KI-VO-E im Auge zu behalten. Die vorgeschlagenen Aufzeichnungspflichten und die Grundrechtsprüfung werden vermutlich zu einem erhöhten organisatorischen Aufwand führen. Arbeitgeber sollten sich daher frühzeitig das notwendige Know-how ins Unternehmen holen, indem das vorhandene Personal entsprechend geschult und/oder externe Unterstützung in Anspruch genommen wird.

Sie möchten mehr über dieses Thema erfahren oder haben konkrete Fragen? Dann nehmen Sie gerne Kontakt zu unseren Fachautoren auf.

Dieser Beitrag wurde zuerst auf dem CMS-Blog veröffentlicht.